Docker, Express, NGINX, AWS ELB를 복합적으로 사용해 고가용성을 위한 애플리케이션 환경을 구축해 봅니다.

로드 밸런싱이 무엇인가요?

로드 밸런싱은 들어오는 네트워크 트래픽을 서버 그룹에 분산하는 데 사용되는 기술 혹은 알고리즘입니다. 모든 공용 사용자에게 서버에서 호스팅 하는 서비스에 대한 단일 진입점을 제공합니다.

프로덕션 서버는 일반적으로 로드 밸런서 뒤에서 실행됩니다. 서버 전체에서 들어오는 부하를 "균등"하게 나워 서버 과부하를 방지할 수 있기 때문입니다.

또한 로드 밸런서는 트래픽을 라우팅 하는 서버에 보조 기능을 제공합니다. 로드 밸런서는 역방향 프락시 역할을 합니다. 역방향 프락시는 서버 그룹과 사용자 간의 중개자와 같습니다. 역방향 프락시가 처리하는 모든 요청은 요청 조건에 따라 적절한 서버로 전달됩니다. 이런 방식으로 역방향 프락시는 구성파일, 토큰, 암호와 같은 민감한 데이터가 저장되는 주 서버에 대한 액세스를 방지하면서 서버의 ID를 익명으로 유지합니다.

로드 밸런서로서의 NGINX와 AWS ELB

NGINX는 역방향 프락시의 역할도 할 수 있는 빠른 무료 오픈소스 로드 밸런서입니다.

반면에 ELB는 아마존 AWS에서 제공하는 로드 밸런싱 서비스입니다. ELB는 ALB, CLB, NLB의 세 가지 유형이 있습니다. 게이트웨이 로드 밸런서라고 하는 새로운 로드 밸런서도 AWS가 제공하는 클라우드 서비스 제품군에 추가되었습니다.

이 튜토리얼의 아이디어는 다중 포트에서 실행되는 고 가용성 Node.js 서버를 제공할 수 있는 계단식의 다중 로드 밸런서 구조를 만드는 것입니다.

* 참고사항

Docker 애플리케이션을 위해 AWS의 자체 ECS, ECR 환경을 활용하는 방법을 포함해 AWS에서 Node.js 애플리케이션을 위한 인프라를 구축하는 방법에는 여러 가지 방법이 있습니다. 하지만 이 자습서에서는 이에 초점을 맞추지 않고 EC2 인스턴스, 로드 밸런서의 메커니즘, 로드밸런싱, 프락시 포트를 통해 Docker와 상호작용 하는 방법을 더 잘 이해하는 것을 목표로 합니다.

아키텍처 개요

이것이 우리가 목표로 하는 아키텍처입니다. AWS와 NGINX에서 관리하는 다중 로드 밸런서는 node 앱을 위한 EC2 인스턴스에서 여러 포트를 관리하는데 도움이 됩니다. 이 아키텍처의 장점은 두 인스턴스가 AZ1과 AZ2의 서로 다른 가용 영역을 가진다는 것입니다. 이로 인해 한 영역이 다운되더라도 다른 영역은 계속 동작할 것이며 두 애플리케이션은 충돌하지 않게 됩니다.

Node.js 앱

단순하게 하기 위해 다음과 같은 표준 스타터 express node 앱을 사용합니다:

const express = require("express");

const app = express();

const PORT = process.env.PORT;

const SERVER_ID = process.env.SERVER_ID;

app.get("/", (req, res)=>{

res.send({server: SERVER_ID, port: PORT});

});

app.listen(PORT, ()=>{

console.log(`Server ${SERVER_ID} is running at ${PORT}.`);

});

포트는 환경변수의 PORT를 사용해 express 앱에 제공됩니다. Docker를 통해 이 포트 값을 제공할 것입니다. docker-compose를 이용하면 간단한 작업입니다. 또 다른 환경 변수인 SERVER_ID가 있지만 데모용일 뿐이므로 걱정하지 마세요.

전체 설정이 준비되면 SERVER_ID는 로드 밸런서가 응답을 가져오는 서버를 알려주는 데 사용됩니다. 이를 통해 다중 로드 밸런서 / 역방향 프락시를 사용하는 인프라 구성이 올바른 방식으로 실행되고 있는지 확인하는데 도움이 됩니다.

이러한 유형의 구성은 프로덕션 파이프라인에서 일반적인 구성입니다. 일반적으로 이 경우 기본 앱 서버는 VPC에 배치됩니다.

한 가지 알아둘 점은 레벨 1 로드 밸런서가 실제 클라이언트의 요청을 처리하기 때문에 공용으로 분류되는 반면 레벨 2 로드 밸런서는 소스 간의 요청을 라우팅 하는 역할을 하는 내부의 로드 밸런서라는 것입니다.

EC2 서버 실행하기.

AWS 계정에 로그인하고 EC2 대시보드로 이동합니다. 다음 단계에 따라 새 서버를 설정하고 Docker를 사용할 준비를 합니다.

1. 대시보드에서 인스턴스 시작을 클릭합니다.

2. 빠른 시작 섹션에서 Amazon Linux 2 AMI를 선택합니다.

3. 인스턴스 유형에서 t2.micro를 선택합니다. 이 대신 원하는 다른 유형을 선택할 수도 있습니다.

4. 이 데모에서 두 인스턴스를 서로 다른 가용 영역에서 동작하길 원하므로 두 인스턴스를 별도로 시작해야 합니다. 이 글에서 리전은 ap-northeast-2 이므로 서브넷은 ap-northeast-2a를 선택했습니다.

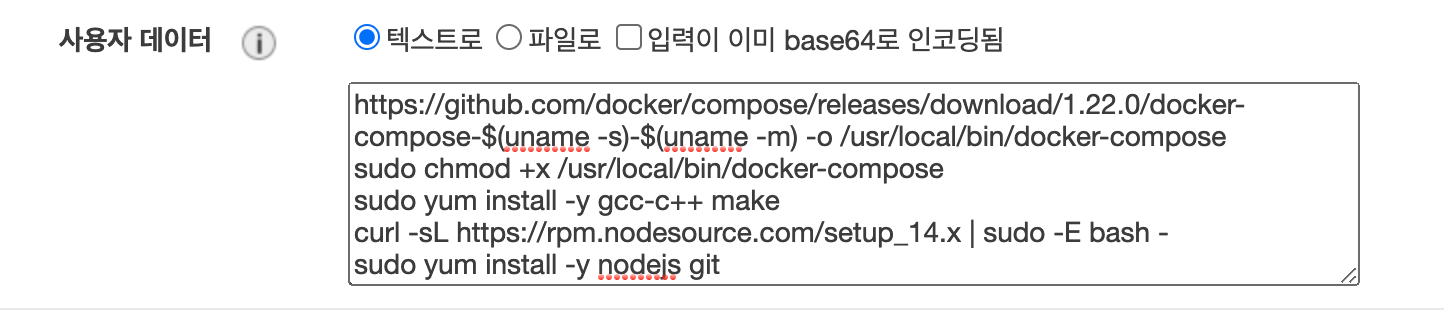

5. 사용자 데이터 섹션 아래에 이 스크립트 코드를 붙여 넣어 node.js Docker 앱을 실행하기 위한 필수 소프트웨어를 설치하게 합니다.

#!/bin/bash

sudo amazon-linux-extras install -y docker

sudo service docker start

sudo usermod -a -G docker ec2-user

sudo chkconfig docker on

sudo curl -L https://github.com/docker/compose/releases/download/1.22.0/docker-compose-$(uname -s)-$(uname -m) -o /usr/local/bin/docker-compose

sudo chmod +x /usr/local/bin/docker-compose

sudo yum install -y gcc-c++ make

curl -sL https://rpm.nodesource.com/setup_14.x | sudo -E bash -

sudo yum install -y nodejs git

6. 스토리지 추가와 태그 추가 섹션은 기본값을 유지한 채 건너뜁니다.

7. 보안 그룹 우성의 경우 포트 22(SSH)와 80(HTTP)이 열려있는 새 보안 그룹을 생성합니다.

IP 범위의 경우 Anywhere 또는 MyIP*8을 선택할 수 있습니다. 테스트 용이므로 아무거나 선택해도 됩니다. 전 Anywhere인 0.0.0.0을 선택하였습니다.

8. 검토 및 시작 버튼을 클릭해 실행시킵니다.

9. 인스턴스에 SSH를 위한 새 키 페어를 생성합니다. 나중에 앱이나 내부 로드 밸런서에 대한 Docker 이미지를 빌드하는데 필요합니다.

이제 두 개의 인스턴스 중 첫 번째 인스턴스가 시작되었습니다. 동일한 단계를 거쳐 다음 인스턴스를 시작하고 서브넷 값을 앞서 생성한 값이 아닌 다른 값으로 변경하고 방금 생성한 SSH 키 페어를 사용해 두 번째 인스턴스를 생성합시다.

앱 컨테이너화와 NGINX 구성.

여기서는 앱을 위해 다음 저장소를 사용합니다: load_balanced_nodejs_app

sowmenappd/load_balanced_nodejs_app

Source code for docker configuration of highly available Node JS app configured with NGINX running on multiple ports - sowmenappd/load_balanced_nodejs_app

github.com

이를 통해 프로세스 속도를 높일 수 있습니다. 저장소의 계층을 보자면 다음과 같습니다.

앱 폴더에는 Dockerfile과 함께 노드 서버 소스 코드가 포함되어 있습니다. nginx 폴더에는 업스트림 서버 포트 구성을 정의하는 구성 파일인 nginx.conf가 있으며 다음과 같습니다:

http{

upstream lb {

server 172.17.0.1:1000 weight=1;

server 172.17.0.1:2000 weight=1;

server 172.17.0.1:3000 weight=1;

}

server {

listen 80;

location / {

proxy_pass http://lb;

}

}

}

이 구성 파일은 메인 NGINX 서버가 포트 80번에서 동작한다고 지정하고 루트 위치 "/"은 lb라는 이 구성 파일에 정의된 업스트림으로 요청(프락시 패스)을 릴레이 합니다. lb는 서버 수를 지정하는 업스트림 객체이며 이 객체는 포함될 서버의 수와 이러한 서버가 내부적으로 실행될 포트를 지정합니다. 여기서 포함될 서버란 docker-compose를 통해 마운트 되는 서버이며 이는 이후 섹션에서 좀 더 자세히 다룹니다. 프락시는 80번 포트의 트래픽 부하를 분산시키게 됩니다.

우리의 경우 업스트림 프락시는 트래픽을 1000번, 2000번, 3000번 포트로 보냅니다. 이 포트 번호는 docmer-compose YAML 파일에서 작성되는 env 변수로 익스프레스 서버 인스턴스에 전송되는 내부 PORT 값과 일치해야 합니다.

각각의 시작되는 인스턴스에 대해 다음 작업을 수행해 줍니다.

1. 생성했던 키 페어를 이용해 인스턴스에 SSG로 연결합니다.

2. 다음 터미널 명령을 수행해 dockerfile로 앱 이미지를 빌드합니다.

git clone https://github.com/sowmenappd/load_balanced_nodejs_app.git

cd load_balanced_nodejs_app/app

docker build -t app .

3. 다음으로 NGINX 서버 이미지를 빌드합니다.

cd ../nginx

docker build -t nginx-s .

4. docker images 명령어를 실행 해 다음과 같은 내용이 표시되는지 확인합니다.

5. 두 번째 서버는 docker-compose.yml 파일을 수정해야 합니다. env 변수중 SERVER_ID는 모든 앱인 app1, app2, app3에 대해 2로 변경해야 합니다.

걱정하지 마세요 프로덕션 서버에서는 이런 일을 할 필요가 없습니다. 이는 데모 목적만을 위한 것입니다.

6. 마지막으로 다음 명령어를 실행합니다.

cd ..

docker-compose up -d

격리된 서버는 이제 백그라운드에서 세 개의 express 앱을 실행하게 됩니다. 이제 필요한 것은 AWS가 제공하는 로드 밸런서인 AWS ALB를 사용하여 이 시스템을 마운트 하는 것입니다.

AWS ALB에 시스템 마운트 하기.

이제 두 인스턴스 모두 마운트 할 준비가 되었습니다. 다음 단계를 따라 AWS에 애플리케이션 로드 밸런서를 설정하도록 합시다.

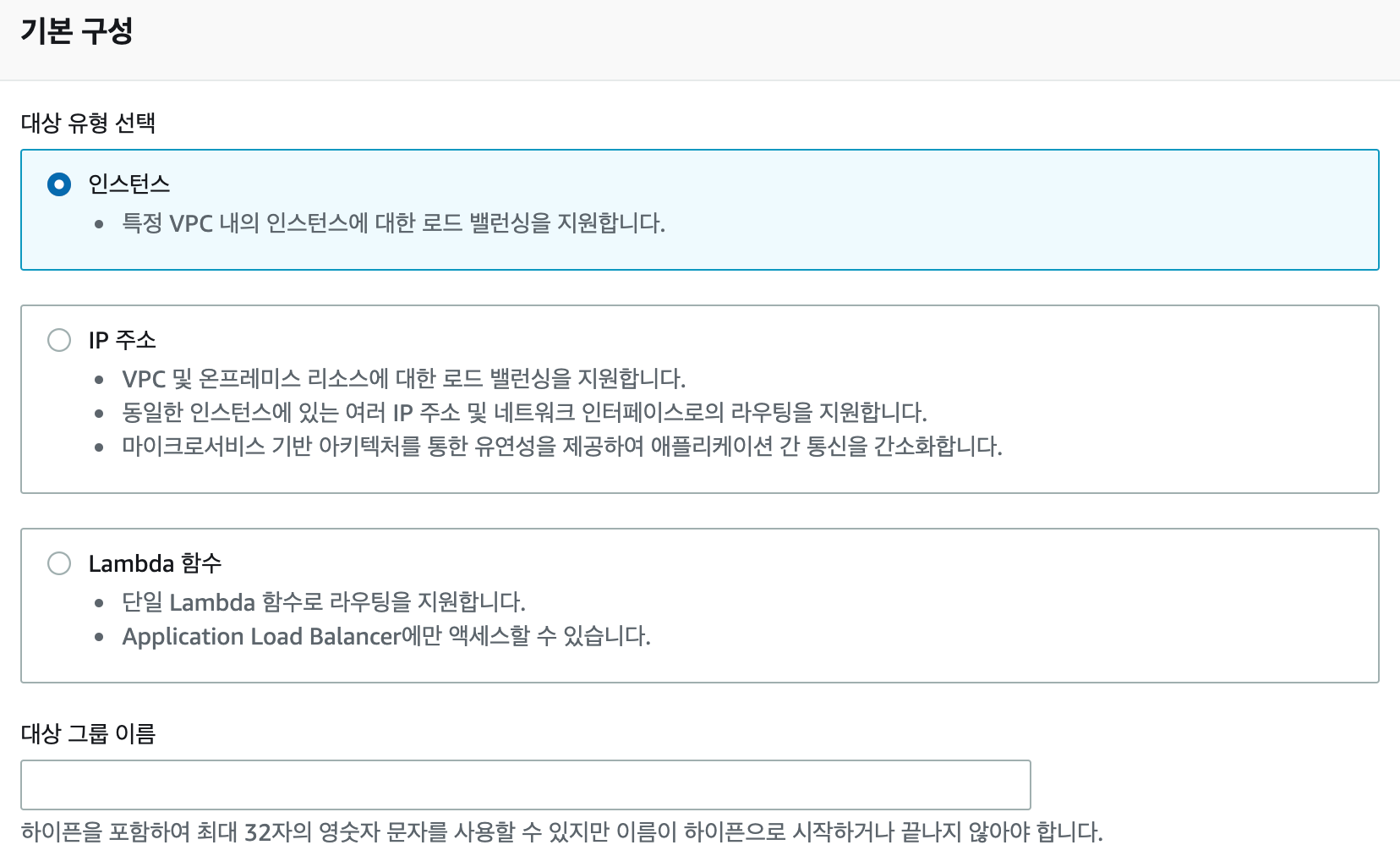

1. EC2 대시보드의 대상 그룹으로 이동해 대상 그룹을 만듭니다.

2. 대상 유형은 인스턴스를 선택 한 뒤 대상 그룹 이름을 작성하고 다음을 클릭하세요.

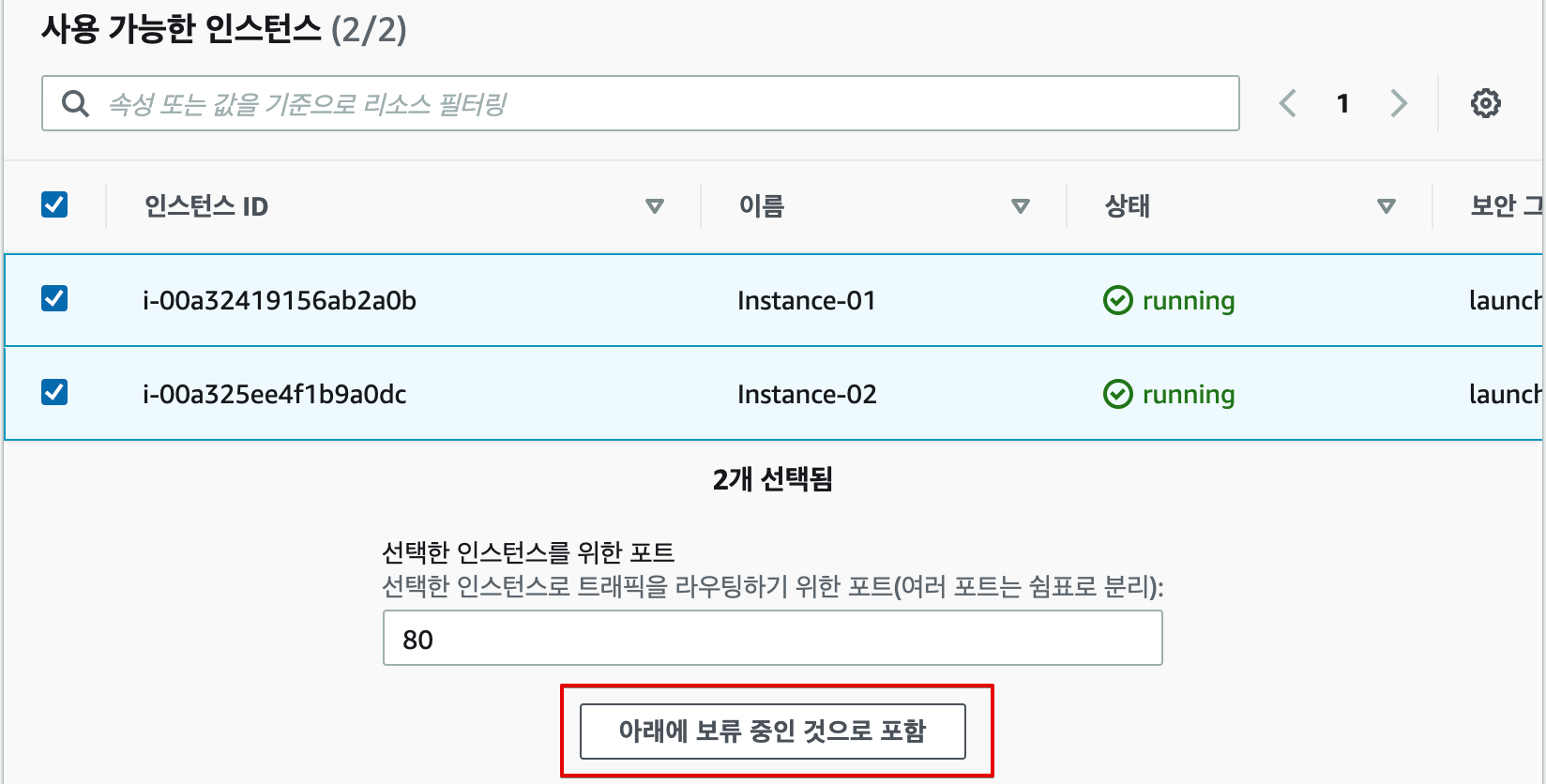

3. 실행 중인 두 인스턴스를 선택하고 선택한 인스턴스를 위한 포트를 80으로 설정한 뒤 아래에 보류 중인 것으로 포함 버튼을 클릭합니다.

4. 보류 중인 항목에 추가된 인스턴스를 확인한 뒤 대상 그룹을 생성합니다.

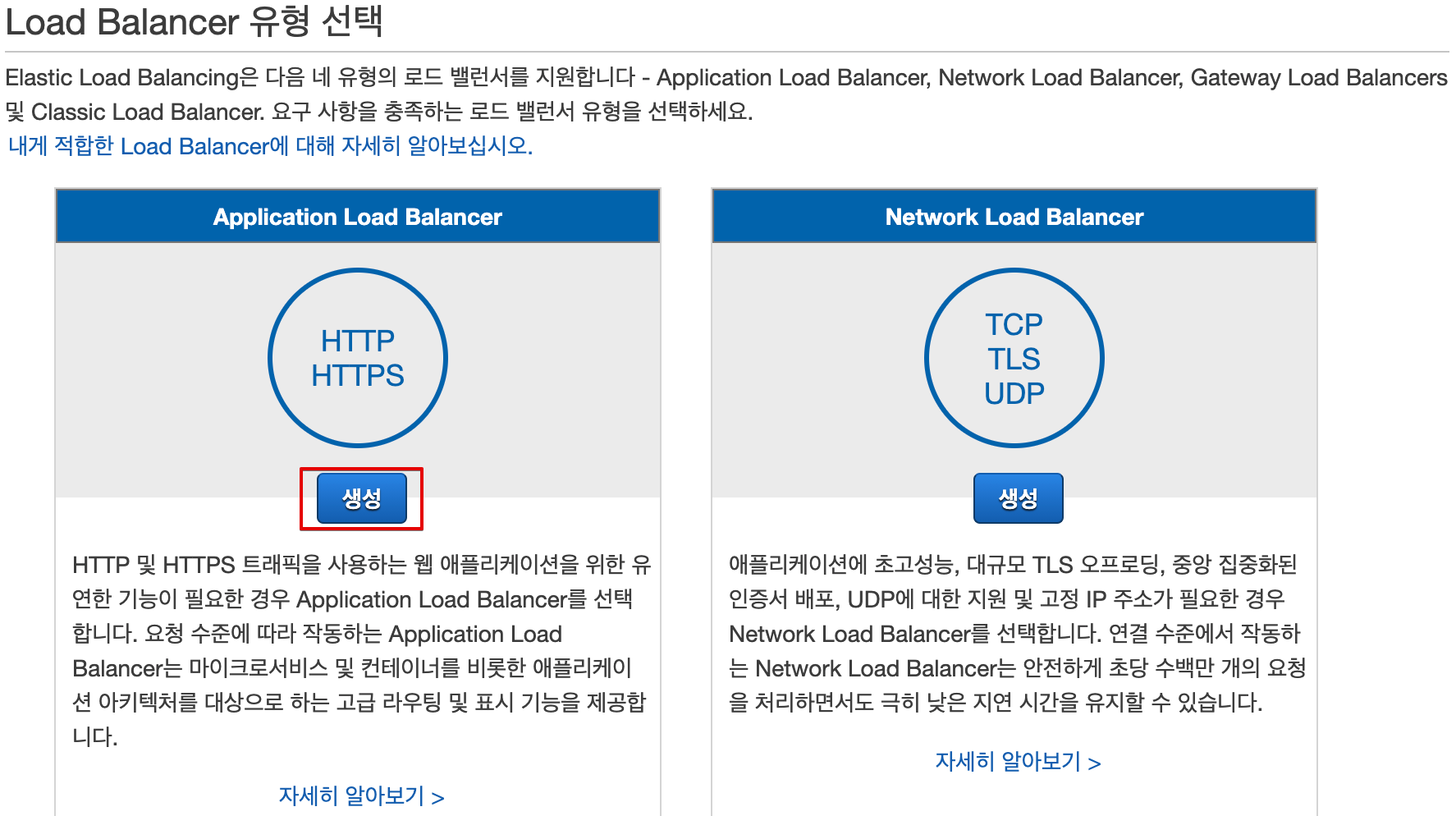

5. 이제 로드 밸런서로 이동해 로드 밸런서 생성 버튼을 클릭한 뒤 Application Load Balancer 생성을 클릭합니다.

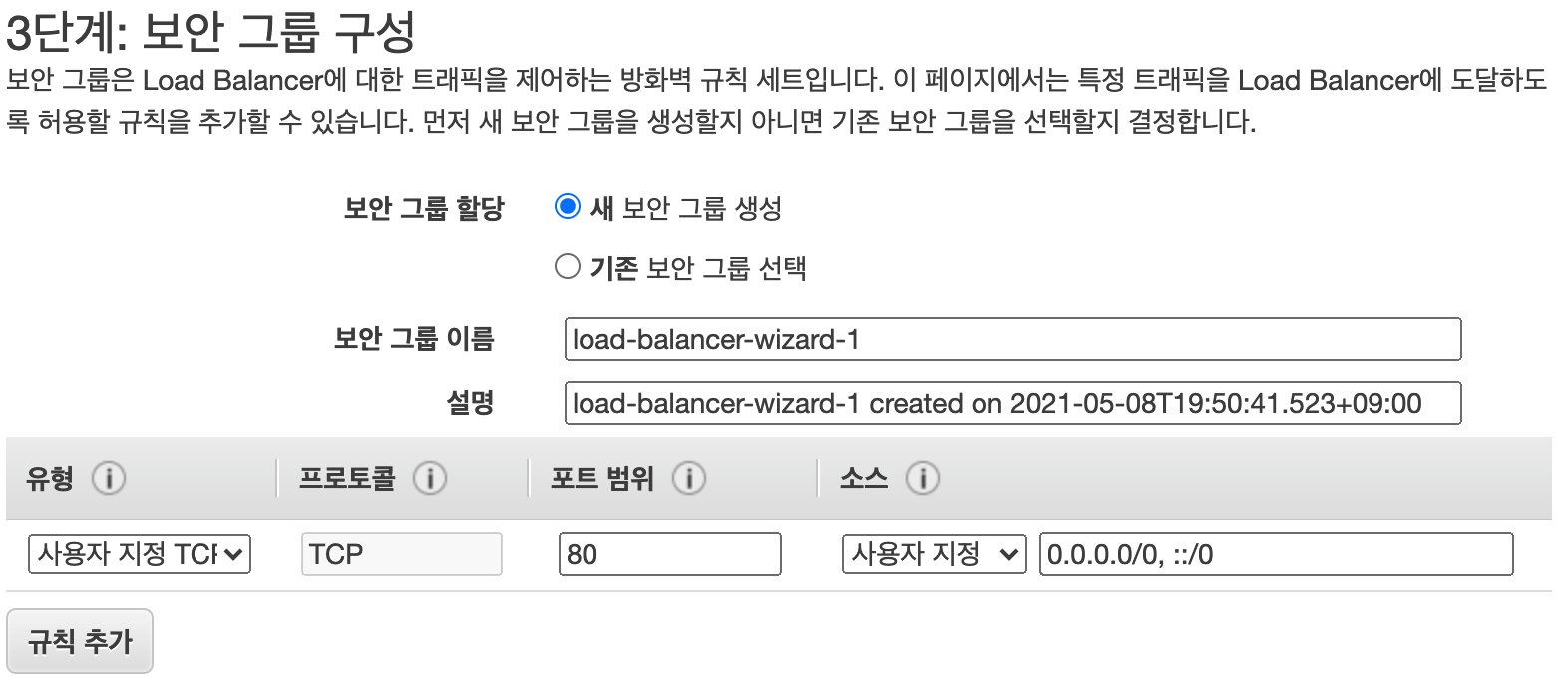

6. 앞서 인스턴스를 생성할 때 선택한 가용 영역을 고른 뒤 계속합니다.

7. 보안 그룹 구성으로 이동해 모든 IP에 대해 80번 포트가 열려있는 새 보안 그룹을 만들고 다음을 클릭합니다.

8. 라우팅 구성에서 앞서 기존 대상 그룹을 고른 뒤 앞서 생성한 대상 그룹을 선택합니다.

9. 설정을 검토 한 뒤 로드 밸런서를 생성합니다. 로드 밸런서는 생성 후 상태 확인을 실행 한 뒤 몇 분 내로 실행되어야 합니다.

이제 EC2 대시보드의 로드 밸런서에서 방금 생성한 로드 밸런서의 DNS이름을 복사합니다.

이 DNS 주소를 브라우저에 붙여 넣고 엔터를 누르세요. 브라우저를 새로 고칠 때마다 SERVER_ID와 PORT가 다른 값을 전송하는 것을 볼 수 있습니다.

이는 기본적으로 NGINX와 AWS 로드 밸런서가 로드 밸런싱을 위해 기본적으로 라운드 로빈 알고리즘을 사용하기 때문입니다.

맺는 글.

이렇게 배포된 시스템은 다중 로드 밸런서의 구성을 통해 높은 가용성을 보장하고 오랜 기간 동작하는 동안 많은 양의 트래픽을 견딜 수 있게 되었습니다. 이 자습서를 뒤이어 소스 제어와 통합 배포 파이프라인을 관리하고 GitHub 저장소에 커밋할 때 변경사항을 서버에 배포하는 방법을 보여주는 또 다른 기사를 게시할 예정입니다.

해당 글은 다음 글을 참고해 번역한 글입니다: Build a highly available Node.js application using Docker, NGINX and AWS ELB

Build a highly available Node.js application using Docker, NGINX and AWS ELB

What is load balancing? Load balancing is a technique(algorithm) used to distribute incomi...

dev.to

'Programming' 카테고리의 다른 글

| [Yarn] PowerShell 환경에서 yarn 작업 시 보안 오류: UnauthorizedAccess 발생 현상 (2) | 2021.07.01 |

|---|---|

| PuTTY로 AWS EC2 인스턴스 원격 접속하기. (0) | 2021.06.11 |

| [NGINX] NGINX 컨닝 페이퍼 (0) | 2021.05.07 |

| [Jenkins | Docker] Jenkins로 Docker 이미지 빌드하기. (0) | 2021.04.18 |

| Fluentd + Elasticsearch + Kibana EFK Stack 구축하기 (0) | 2021.04.17 |