앞서 작성한 code-server에 HTTPS를 적용해 보도록 하겠습니다. 이번 글에선 certbot의 nginx옵션 이용해 인증서를 발급받고 적용해 보도록 하겠습니다.

편의를 위해 code-server 설치와 nginx를 통한 역방향 프록시 설정에 대한 설명은 스킵하도록 하겠습니다.

01. code-server 설치 및 역방향 프록시 설정.

다음 글을 참고하여 code-server를 미리 준비합니다: https://smoh.tistory.com/456

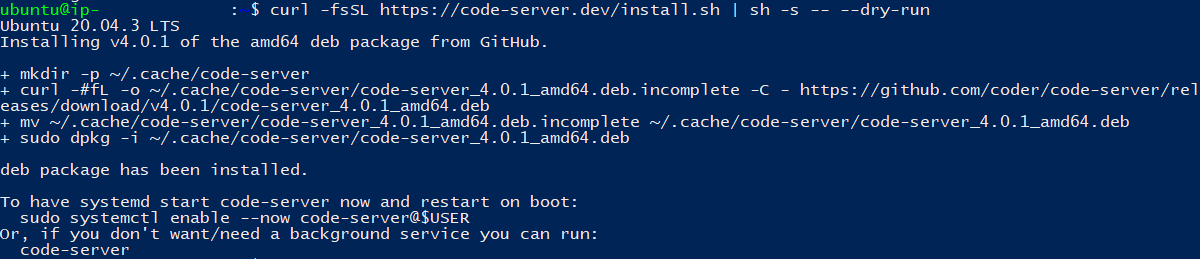

[Ubuntu] 아이패드에서 code-server로 코딩 공부 해보기.

아이패드에서 프로그래밍 공부를 해보고자 여러 어플을 찾아봤습니다. 파이썬 같은 경우는 적당한 유료 어플이 있었지만 VSCode와 같은 무료면서 강력한 기능을 가진 어플은 없었습니다. 다양한

smoh.tistory.com

** 위 글에선 예시를 위해 AWS의 EC2를 사용하였습니다만 현재는 관리하는 서버에 code-server를 옮겨둔 상태입니다.

** NGINX를 통한 역방향 프록시 설정 방법은 별도로 설명하지 않습니다.

02. CERTBOT 설치.

만약 apt 같은 OS 패키지 관리자를 사용하여 설치된 Certbot 패키지가 있는 경우 기존 Certbot은 제거해야 합니다. 다음 명령어로 Certbot을 제거해 주세요.

sudo apt-get remove certbot

이제 snap을 사용해 최신 Certbot을 설치해 줍니다. 다음 명령어로 snap을 사용해 Certbot을 설치합니다.

sudo snap install --classic certbot

설치가 완료되면 다음 명령어를 실행해 certbot 명령을 실행할 수 있는지 확인합니다.

sudo ln -s /snap/bin/certbot /usr/bin/certbot

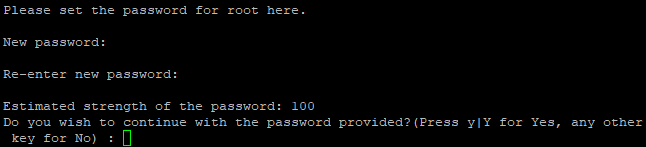

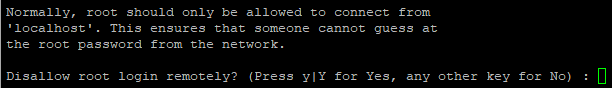

이제 다음 명령어를 수행해 인증서를 발급받습니다.

sudo certbot certonly --nginx

만약 nginx에 여러 개의 사이트가 등록되어 있으면 위의 그림처럼 리스트가 나열됩니다. 발급을 원하는 사이트의 번호를 입력합니다. 만약 입력하지 않는 경우 모든 사이트가 선택됩니다.

이제 인증서 발급이 완료되었습니다. 인증서의 위치는 /etc/letsencrypt/live/사이트명 폴더에 저장됩니다.

03. NGINX 설정 변경.

다음 명령어를 통해 nginx의 설정 파일을 엽니다. 전 별도 설정 파일에 server 설정을 관리하고 있습니다. 설정 파일 이름은 사용자에 따라 다릅니다.

sudo vi /etc/nginx/conf.d/my-server.conf

설정 파일을 열고 다음과 같이 설정을 추가합니다.

#/etc/nginx/conf.d/my-server.conf

#code-server

server {

listen 80;

server_name your.domain.here;

location / {

proxy_pass http://localhost:{PORT};

proxy_set_header Host $host;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection upgrade;

proxy_set_header Accept-Encoding gzip;

}

listen [::]:443 ssl ipv6only=on;

listen 443 ssl;

ssl_certificate /etc/letsencrypt/live/your.domain.here/fullchain.pem;

ssl_certificate_key /etc/letsencrypt/live/your.domain.here/privkey.pem;

include /etc/letsencrypt/options-ssl-nginx.conf;

ssl_dhparam /etc/letsencrypt/ssl-dhparams.pem;

}

이제 다음 명령어로 nginx 서비스를 재시작합니다.

sudo service nginx restart

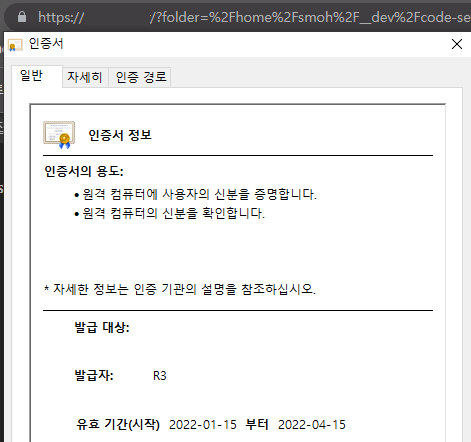

접속해서 확인해 봅시다.

도메인에 접속하면 https가 정상적으로 적용된 것을 확인할 수 있습니다.

'Programming > Linux' 카테고리의 다른 글

| [Ubuntu] 아이패드에서 code-server로 코딩 공부 해보기. (0) | 2022.01.15 |

|---|---|

| [Jenkins] Ubuntu Jenkins에서 Docker permission denied 문제 수정 (0) | 2021.10.24 |

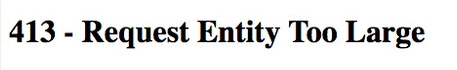

| [Nginx] 413 Request Entity Too Large (0) | 2020.12.04 |

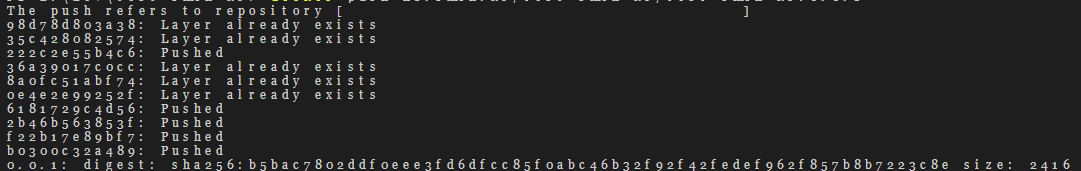

| [Harbor] unauthorized to access repository, action: push: unauthorized to access repository (0) | 2020.12.04 |

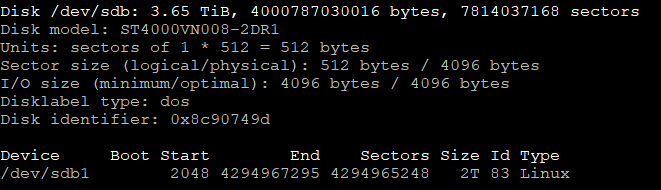

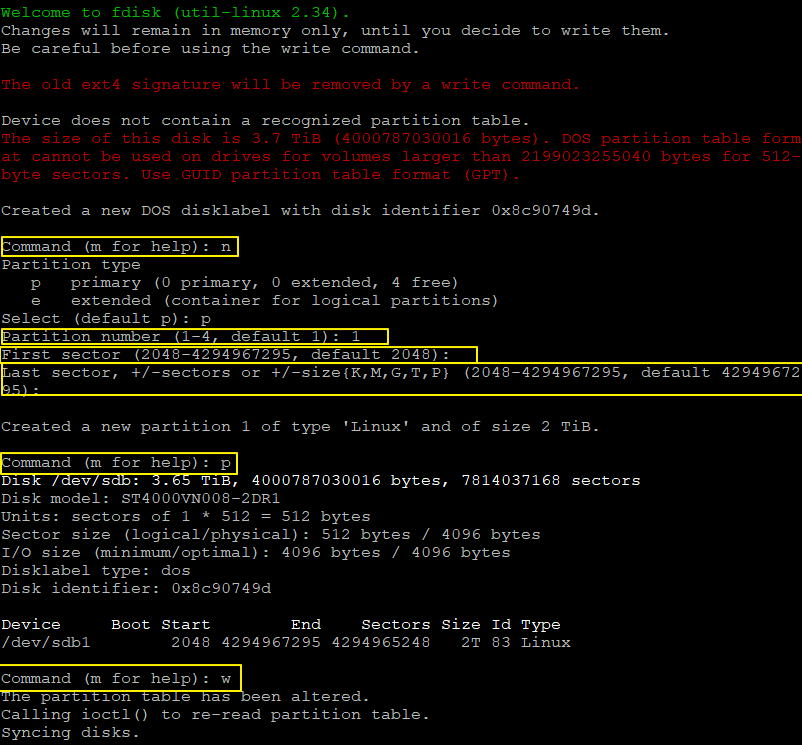

| [Ubuntu] 대용량 디스크 추가하기. (0) | 2020.11.30 |